First things, first…

Existen dos estilos de resolver un problema software, que podríamos denominar "al estilo tradicional" o determinista y "mediante inteligencia artificial" o probabilístico.

Lo más seguro es resolverlo del modo tradicional, ya que, resuelto de forma determinista, el comportamiento es predecible, pero, son tantos los problemas a los que nos enfrentamos que, algunos, requieren otro enfoque en el planteamiento de la solución.

Cuando un problema no puede resolverse con algoritmia tradicional, debería emplearse un enfoque de inteligencia artificial en el planteamiento de su solución.

Lo que muchas personas, quizá por desconocimiento, no tienen siempre presente, es que una solución IA, ofrece un resultado probabilístico. Por ejemplo, si a partir de una fotografía debe determinar si el animal retratado es un perro o un gato (en nuestro universo, para este ejemplo, solo existen esos dos animales), una solución IA, nunca nos proporcionará una respuesta precisa, sino que nos dirá, en todo caso, que la imagen corresponde en un X% a un perro y en un (100-X)% a un gato, seguido de un "ahora decida usted, que yo hago lo que Pilatos".

Claro, como todo en la vida, como decía el Sr. Donés, "depende de según como se mire",.... y es que hay fotos y fotos …. Aunque la solución tendrá más o menos puntería dependiendo de cómo haya sido desarrollado el "modelo" (así llamamos a las soluciones IA). Y como todas basan sus respuestas en datos, el ingeniero de inteligencia artificial obtendrá un modelo más eficiente o menos, dependiendo (entre otras cosas, pero sobretodo) de la información (datos) que utilice.

Déjenme explicar esto mejor, que resultará esencial un poco más abajo:

¿Cómo se genera un modelo IA?

Se genera a partir de un algoritmo ya existente, al que se le proporcionan datos (simplifiquemos diciendo que fotos de perros y de gatos), acompañados de la palabra "perro" o "gato" (etiquetas). El algoritmo, entonces, revisa estos datos y las etiquetas, y poco a poco, va sacando sus conclusiones, a partir de fórmulas matemáticas, y aprendiendo a diferenciar entre perros y gatos. Cuando ha repasado los datos lo suficiente, genera un sistema (modelo) que, a partir de una foto, responde diciendo en qué porcentaje la fotografía (es un) se corresponde a un perro y en qué porcentaje a un gato.

Así que, claro está, este modelo será más o menos preciso dependiendo de la calidad y variedad de los datos con los que haya sido "entrenado".

Cómo siempre, la información es poder y el equilibrio es algo básico.

Por ejemplo, si el conjunto de datos de entrenamiento existen 1000 fotos de gatos y 1 foto de un perro, el modelo tendrá bastante claro cómo son los gatos pero no tanto como son los perros, y si luego se le proporciona una foto de un perro "afelinado" (permítaseme la expresión), probablemente lo confunda con un gato.

Ese ejemplo de proporciones en el conjunto de datos de entrenamiento es lo que en IA se llama un "conjunto de datos desbalanceado".

Y claro, diferenciando entre perros y gatos, poca repercusión tiene un conjunto de datos desbalanceado, ahora bien, imaginemos un modelo de datos que deba recomendar si retener a un sospechoso o no, e imaginemos que ha sido entrenado con un conjunto de datos en el que los datos etiquetados como "posibles delincuentes" son, en su inmensa mayoría personas de origen africano…. Efectivamente, tal y como usted está pensando, todos los delincuentes de origen caucásico estarían celebrando la existencia de este modelo, y…. Probablemente una gran mayoría de las personas honestas de origen africano tendrían serías preocupaciones.

Cuando un modelo se entrena con datos desbalanceados, adquiere "vicios"... A esos "vicios" les llamamos sesgo. Poco más o menos es lo mismo que si a un niño de un año le enseñas 1000 fotos de un gato y una de un perro,.... sabrá identificar muy bien a los gatos y muy mal a los perros, y es muy probable que se equivoque, generalmente en favor de los gatos.

Podríamos afirmar que, el sesgo (o la inexistencia de sesgo), al igual que el tamaño (del conjunto de datos), importa.

Y ahora sí, entrando un poco más en el barro, es probable que entendamos el motivo por el que muchas soluciones basadas en IA no funcionan como es de esperar ….

La culpa no es de la IA, no, la culpa, porque (oiga, con el debido respeto) siempre hay que culpar a alguien o a algo, es de los datos (o de la elección de los mismos, o de cómo se han tratado antes de entrenar con ellos al algoritmo, o … (aunque esto es menos probable, no vayamos a pensar mal, por favor) de las intenciones de la persona que ha generado el modelo.

Y escribo esto porque hay mucha controversia últimamente (o eso me parece a mí) al respecto de la IA, hay personas que no la entienden de la forma en que creo debe entenderse, y otras que desconocen sus posibilidades (además, el cine lo magnifica todo….) pero lo que sí es cierto es que (como en toda materia disruptiva -que no destructiva-) existen opiniones polarizadas. y creo que las opiniones extremistas, en ocasiones, no son buenas.

Ahora, que mas o menos el lector empieza a intuir la motivación de este post, entremos un poco más en materia

¿un antes y un después?... ¿o lo mismo de siempre otra vez?…

“Nos va a quitar el trabajo”, “no es ética”, “es el mismo diablo, pero con piel de cordero”. “predestinada para el mal”, “no funciona”, “nunca sustituirá a las personas”, “la IA trae el sesgo consigo y no se puede eliminar”, “margina a determinados grupos”, “es una herramienta para dominar a la humanidad”

Si uno busca a fondo, si pregunta en sus círculos y en otros,.... Es decir, que si se investiga un poquito este asunto, se encuentran todo tipo de opiniones equivocadas y es que…. centrándonos en algunas de las críticas se intuye un cierto desconocimiento.

Vamos a ello, tomemos, por ejemplo, las siguientes críticas a modo ilustrativo y desgranémoslas.

Eliminación de mano de obra humana.

Hay muchas personas que afirman que la inteligencia artificial no debe ser aplicada, porque elimina mano de obra, y expresan ésta misma idea de diferentes formas.

Bien, creo que deberíamos centrar el análisis comenzando por la siguiente reflexión:

¿Qué tipos de tareas son automatizadas con IA? En general, las siguientes:

Tareas muy repetitivas

como, por ejemplo, las propias de una cadena de montaje, donde robots, controlados por un software que en ocasiones incorpora una inteligencia artificial, realizan tareas rutinarias, como atornillar, contar (enumerar) o analizar piezas para detectar fallos de fabricación.

Respecto a este caso, es verdad que un robot sustituye a una persona, pero deberíamos pensar que, además de ser un trabajo poco agradable y al que un humano no aporta valor añadido, por ser rutinario y tremendamente repetitivo, es muy probable que se generen errores humanos. Por ello, una máquina, que no se cansa, aporta más eficiencia.

Claro, pero hay personas perjudicadas, me dirán ustedes,....bueno, yo creo que es responsabilidad de la empresa formar y reciclar a estas personas, de modo que aporten valor añadido en nuevas tareas, como el control de estas máquinas, mantenimiento correctivo del producto fabricado u otras actividades donde las personas aporten algo que las máquinas, hoy por hoy, no pueden aportar.

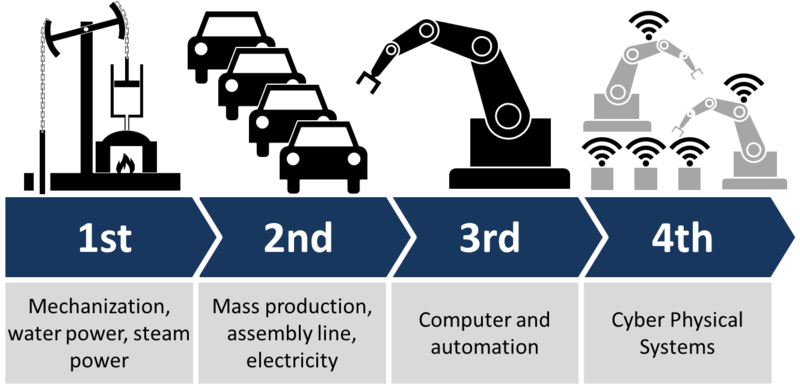

Algo similar ha ocurrido ya muchas veces de forma más global o más localizada, en el pasado (y oiga, de momento, hemos salido adelante). A modo de ejemplo, podemos referirnos a la controversia que se generó, allá por el año 1784/1785, cuando se diseñó primero, y se perfeccionó después, el telar mecánico.

El telar mecánico es uno de los inventos más comentados de la primera revolución industrial. Es cierto que muchas personas se reciclaron, cambiaron de oficio (algunas aprendieron a reparar telares mecánicos). Por supuesto, otras muchas se atascaron (quizá por edad, quizá por falta de iniciativa) y no consiguieron reubicarse.

Claro, hay para todos los gustos, pero qué duda cabe de que el progreso industrial facilita, a su vez, el progreso personal,... es ya cuestión de la voluntad de cada uno, evolucionar o no, pero creo que, el mismo instinto de supervivencia lleva, a la mayoría a reciclarse.

La pregunta es, para mi, entonces,...¿debe una persona estancarse o debe evolucionar?

Desde otro punto de vista, podría valorarse igualmente que, la introducción de esta máquina en la industria textil incrementó la producción, y con ello, surgieron nuevas actividades, de carácter comercial, de carácter logístico (distribución, almacenaje,...) y además se estimuló a otros subsectores (se necesita mayor producción de materias primas, por ejemplo).

Por ello, puede afirmarse (unos pocos años después, tras haber analizado el caso miles de personas) que si bien destruyó algún empleo, el porcentaje más elevado de las personas que perdieron su empleo se reciclaron en poco tiempo, y que, además, la introducción del telar mecánico generó muchos empleos, tanto directos como indirectos, además de estimular la economía (británica primero e internacional después) de forma significativa.

Este caso, se ha repetido a lo largo de la historia tantas veces, que podríamos dedicar un blog entero a explicarlas una por una, y siempre han tenido el mismo efecto.

Por mencionar de forma breve otro más, podríamos poner sobre la mesa la introducción de los vehículos híbridos, en cuya fabricación fué pionera la nipona Toyota, seguida de su compatriota Honda. Desde luego, yo no llevaba mi Prius (al principio) al taller del barrio, donde Juan, el propietario, ya mayor, y su hijo Adolfo (recuerdo que de pequeño jugábamos juntos al fútbol en el descampado de la esquina,.... snif…) no sabían “meterle mano” a esas máquinas. Claro que perdieron negocio, pero escalemos el caso y valorémoslo del mismo modo que hemos hecho con el del telar.

Y, de verdad,... así todo, la historia se repite, una y otra vez,.... y cada vez, surgen voces críticas…. y cada vez salimos adelante, reforzados y más eficientes…, y me pregunto yo, ¿no será que el círculo de confort tiene un pequeño escalón que nos da vértigo y por eso no salimos del mismo.

Tareas en las que se analiza un volumen inmenso de datos

o, en general, de complejidad muy elevada. En este caso, y aunque en determinados sectores se identifican personas que se muestran reticentes a la incorporación de la inteligencia artificial, es justo reconocer que las más de las veces sectores como la ingeniería y la medicina abrazan con cariño las soluciones de inteligencia artificial, ya que vienen a poner al servicio de las personas la capacidad de inferencia, de detección de patrones y de análisis de información tan elevada que las matemáticas y la informática permiten.

Claro, en este caso, la IA supone un apoyo, una ayuda, ya que ninguna (o casi ninguna persona) tiene la capacidad de procesar tantos datos o de forma tan eficiente como los sistemas de IA.

Por ejemplo, podemos hablar de sistemas destinados a identificar el riesgo de carcinoma a partir de imágenes obtenidas del sujeto. En este caso, los sistemas de IA suponen una ayuda inestimable para la toma de decisiones, que finalmente adopta un profesional especializado, valorando las imágenes, la información arrojada por el sistema y revisando sus propios conocimientos en el campo.

Muchas personas que se muestran críticas, formulan preguntas tales como: ¿confiarías en el diagnóstico de una IA?

A ver, a ver,.... centrémonos un poco, por favor, porque la IA no emite el diagnóstico, la IA es una herramienta útil al servicio de un médico especialista, que basará el diagnóstico que él mismo emite según su criterio y actitud profesionales, confiando, en mayor o menor medida, en una IA si es que dispone de ella en su desempeño.

Otro caso que, aunque trataremos después con algo más de detalle, podría ser el de análisis de riesgo en operaciones financieras (por ejemplo, autorización de límites de crédito).

En este tipo de soluciones es donde desempeña(rá) un rol fundamental lo que se viene a denominar “IA explicable”, es decir, sistemas de IA que son capaces de arrojar datos que permiten comprender a la persona que los utiliza el motivo de la recomendación. Será la persona quien decida, finalmente, apoyándose más o menos en la recomendación del modelo de inteligencia artificial. Pero insisto,.... más adelante entraremos en razones y explicaciones al respecto de casos tan controvertidos como este del sector financiero. Quedémonos por ahora con que la IA supone un apoyo al humano cuando se procesan de forma automática volúmenes de datos ingentes.

Tareas que suponen un riesgo para el ser humano

Todos nos acordamos de aquellos incendios (terremotos, etc…) en los que fallecían bajo el fuego profesionales de la seguridad. Y todavía ocurre, por desgracia.

Creo que queda claro que la aceptación de la IA en estos campos es muy amplia, del mismo modo que la IA en este campo es imprescindible para el progreso y la supervivencia humana.

Podríamos continuar con una tipología infinita, pero la realidad es que nos encontramos inmersos en otra revolución industrial, en la que la IA desempeña un papel muy relevante y a la que debemos acostumbrarnos, identificar qué valor diferencial aporta el humano y centrarnos en ello para marcar esa diferencia que, siglo tras siglo, ha marcado la humanidad en su entorno.

No funciona

Se habla de tres riesgos fundamentales en la IA:

- Accidentes

- Malos usos

- Carrera armamentística

Es cierto que son riesgos, ahora bien, ¿son riesgos de la IA?. Yo creo que aunque son riesgos que surgen con el uso de la IA, no son, hablando con propiedad, riesgos de la IA.

Vamos a ir viendo estos riesgos uno a uno, descartando en primer lugar el de la

escalada armamentística,

ya que al final son decisiones sobre el uso de la IA, no de la IA. Claro,... si la IA no existiera, no se hablaría de este riesgo, propio de la naturaleza, de la conducta, de la política y de la ética (perdón,perdón.... luego trataremos esto) humanas, pero, repito, si no existiera la IA no tendríamos robots que se defienden bien en entornos hostiles, como avalanchas de nieve, terremotos o incendios, sin que la vida de personas se pongan en juego.

Malos usos

Existen muchos malos usos, y para comprender que no es culpa de una solución IA, sino del uso que se haga de ella, el primer punto a considerar es que, hoy por hoy, una IA no tiene conciencia, no diferencia, con independencia del contexto, el bien del mal.

Pongamos un ejemplo práctico. Existen sistemas de IA que identifican personas, y otros que permiten hacer seguimiento en tiempo real, mediante cámaras de vídeo, de personas o de objetos móviles. Sin duda, muchas personas estarán de acuerdo en la aplicación de estos sistemas para el seguimiento de personas pertenecientes a un grupo terrorista que pretende incendiar un centro comercial, para obtener pruebas, detenerlos y ponerlos a disposición judicial. Eso sí, el mismo sistema podría utilizarlo un gobierno totalitarista para perseguir, y tras ello asesinar, a personas que no comparten sus ideales y que ese gobierno identifica como una amenaza al régimen, y es muy probable que el lector opine que ese es un uso malo de la IA.

Entonces, si es el mismo sistema, ¿la culpa (recordemos que siempre hay que culpar a alguien o a algo,... sino no arreglamos el mundo) es de la existencia del sistema o la responsabilidad recae en las personas?

Accidentes

Este caso, un poco más sensible de tratar, por tener que precisar un poco más.

Debemos introducir en este punto que todo proceso de implementación de software debe cumplir una serie de pasos en un orden concreto. Esto aplica, con metodologías específicas como CRISP-DM, a los proyectos IA (proyectos puros de IA o proyectos que incluyen IA).

Todos los procesos de desarrollo de software correcto consideran diferentes tipos de pruebas en distintos escenarios, por lo que, entendiendo accidente como un comportamiento anómalo del sistema, debe entenderse que el accidente surge de la aplicación incorrecta del proceso de desarrollo del software.

Pasemos a explicar este asunto con un ejemplo:

El caso de los vehículos autónomos es un ejemplo clarísimo. ¿Qué proceso de desarrollo de este tipo de herramientas debe aplicarse? ¿Qué tipo de pruebas y en qué entornos debe diseñarse para evitar “accidentes”?

Entramos en un terreno en el que de nuevo, los datos con los que se entrene a los modelos o, si hablamos de otro tipo de IA, la estocasticidad y políticas de entornos y agentes, son determinantes.

Otro caso típico podría aplicarse a medicina. ¿Importa la cantidad y variedad de imágenes para detectar con una IA un riesgo alto de existencia de algún tipo de formación cancerosa? ¿deberían ser necesarias pruebas exhaustivas para validar la calidad del sistema antes de utilizarlo en casos reales?

Entonces, ¿es un problema de la inteligencia artificial o del proceso concreto de ejecución del proyecto de desarrollo de software? En otras palabras, ¿es un problema derivado del proceso de gestión del proyecto o del algoritmo? Ahí lo dejo,...

Creo que, sin que haya que entrar en más detalles o ejemplos, queda claro que el proceso de gestión de desarrollo de proyectos es esencial y debe ajustarse a cada caso concreto, sin que el problema resida en el algoritmo o en la tecnología per se.

Se utiliza para el mal

Este caso, creo que es muy sencillo de tratar:

¿Quién utiliza la IA para el mal? ¿Y las escopetas de caza?¿Y un bote de spray pimienta? ¿Quién utiliza un cuchillo para el mal?

Creo que la existencia de personas que utilizan “indebidamente” un cuchillo, no es motivo que justifique la inexistencia de los cuchillos, de verdad, a mi, para cortar cebolla, me vienen genial, no sé a vosotros…. Yo voy a defender, con mi vida si es necesario, la existencia de cuchillos, aun a riesgo de que los usen contra mi.

El sesgo no se puede eliminar, y perjudica a colectivos

El sesgo (bias) es un efecto que aparece en los datos puede aparecer, de forma independiente, en cualquier variable estadística de un conjunto de datos, y como ya se ha comentada arriba, se debe a una condensación o agrupación de valores próximos a un punto (a una cifra).

Eliminar el sesgo es tan sencillo como ir eliminando valores del conjunto hasta conseguir una distribución equilibrada (simétrica, respecto a un punto de referencia neutro)

Es posible que haya que eliminar tanta información del dataset que este quede inservible, pero solo ocurre a veces. Este es el motivo por el que hay personas que afirman que el sesgo no puede eliminarse, sin darse cuenta (vamos a pensar bien) de que el conjunto de datos lo elige (o lo crea) el ingeniero o el científico de datos, y si un dataset no vale por tener mucho sesgo, la solución es tomar otro.

También es posible que, en determinados casos, el sesgo lo inyecte un determinado algoritmo, por error (recordemos, como decía al principio, que los algoritmos, al analizar los datos, generan modelos). Bueno,.... por eso hay diferentes algoritmos para un mismo cometido, si se analiza la data y se observa correcta y, sin embargo, se detecta sesgo en el modelo, puede probarse a modificar sus parámetros e hiperparámetros o bien probar con otro algoritmo.

Muchas personas que desarrollan inteligencia artificial afirman (y me incluyo) que la tarea más difícil no es generar o crear un modelo, sino obtener un conjunto de datos adecuado. Esto es tan cierto que metodologías como CRISP-DM hacen hincapié en el tratamiento de los datos y no en la generación del modelo.

Cualquier ingeniero de inteligencia artificial que se preocupe por la calidad de su trabajo, va a dedicar su tiempo a la eliminación del sesgo, a trabajar hasta conseguir un conjunto de datos balanceado. Por ello, si alguien afirma que el sesgo no ser puede eliminar, quizá se haya rodeado de personas que trabajan la IA sin un objetivo de calidad o sin los conocimientos adecuados, por lo que, si tras leer esta explicación sigue opinando igual, mi respuesta sería "dime con quién andas, y te diré quién eres". Si, quizá os suene un poco radical,... pero si alguien no atiende a razones justificadas estadísticamente,.... mejor dejarle atrás con sus creencias, quizá, limitantes, -al menos esa es mi opinión-.

No es ética

Y llegamos, al alcanzar este punto, al punto central de esta nota breve, aunque tras todo el recorrido que hemos hecho, poco más queda por añadir…

Bien,.... centrémonos primero en dirimir qué es la ética, creada por el filósofo Aristóteles hace ya unos cuantos años.

Disciplina filosófica que estudia el bien y el mal y sus relaciones con la moral y el comportamiento humano.

En primer lugar me asalta una duda, y es la siguiente: ¿Cómo pretendemos que una creación humana sea ética si, las más de las veces, el ser humano no lo es?

Pero bueno, más allá de disquisiciones pseudo-filosóficas, debemos reflexionar, de nuevo, sobre qué es un modelo de IA, es decir, (valga está como definición informal) un sistema software que, basándose en cálculos estadísticos y matemáticos, y a partir de un conjunto de datos, extrae patrones y relaciones entre ellos, de tal modo que, a partir de una estructura de datos de entrada, genera una información resultante. Algo así como “DATOS→ANÁLISIS→INFORMACIÓN”.

Y digo yo que, para diferenciar entre el bien y el mal (conciencia), habrá que tener consciencia, es decir, no actuar de forma automática, y una IA es un sistema automático.

Podríamos seguir dándole vueltas y hasta pensar en generar una IA que, dentro de un contexto específico, diferencie si una serie de datos (entrada) está bien o mal, y extender esto a muchos contextos, claro está, siempre cuidando de los datos (evitando sesgo, siempre en la rueda,... siempre lo mismo, así es, por eso es tan importante ser cuidadoso con los datos), … pero .. sinceramente, aunque me gustaría, seguir “buscándole 3 pies al gato”, el metro ya ha llegado a la estación en la que me tengo que bajar (y voy con prisa).

Otro día, hablaremos de otro tema.

Hasta pronto.

Jerónimo Molina

Este comentario ha sido eliminado por un administrador del blog.

ResponderEliminarEste comentario ha sido eliminado por un administrador del blog.

ResponderEliminar